米スタンフォード大学、456ページのAI動向調査レポート公表…要点を速報

●この記事のポイント

・米スタンフォード大学の人間中心AI研究所はAI動向を調査したレポート「2025 AI Index Report」を公表。

・事実性評価の欠如によるハルシネーションリスクが指摘されている。

・日本語を含むグローバルなAI性能動向の把握、サービス業におけるAI導入事例と効果なども記述。

米スタンフォード大学の人間中心AI研究所は7日、AI動向を調査したレポート「2025 AI Index Report」を公表した。同レポートは政府や産業界の協力の下で同研究所が毎年、調査・発表するもの。AI開発の最新動向や将来、ビジネスのヒントになる要素なども満載だが、全体で456ページにおよぶため、すべてを精読するには労力と時間を要する。そこで、専門家に要点を解説してもらう。

●目次

- ノーコードRAG製品のPoC実績があるユーザ向けを想定

- (1)事実性評価の欠如によるハルシネーションリスクの指摘

- (2)AI活用におけるセキュリティリスクと対応の遅れ

- (3)日本語を含むグローバルなAI性能動向の把握

- (4)サービス業におけるAI導入事例と効果

- (5)国際的な評価フレームワークとベストプラクティスの動向

RAG(検索拡張生成:大規模な言語モデルの出力を最適化するプロセス)の導入を検討中で、リスクや精度評価などについてさまざまな懸念も持つ日本企業にとって、同レポートのどの部分に注目すべきかという観点で、AI開発・研究者でメタデータ社長の野村直之氏に解説してもらった。

ノーコードRAG製品のPoC実績があるユーザ向けを想定

特に以下の3点に関心を持ち、かつノーコードRAG製品のPoC(概念検証:試作開発に入る前段階の検証プロセス)実績があるユーザ向けを想定し、同レポートのポイントをピックアップしたいと思います。

・組織内ドキュメント検索を中心としたナレッジマネジメント

・事実性の誤り、セキュリティ(組織内の部署ごとの知識アクセス権管理など)

・サービス業全般への恩恵

(1)事実性評価の欠如によるハルシネーションリスクの指摘

同レポートでは、モデル性能の急速な向上に対し、事実性や真実性を評価する標準的な手法がまだ十分に確立・普及していないことが強調されています。特に、生成AIの出力の事実誤り(いわゆるハルシネーション)を検出・防止するためのベンチマーク(例えばTruthfulQAなど)が広く活用されていない現状が示されており、社内ナレッジにRAGを導入する企業にとっては注意が必要だと指摘されています。この部分から、現在どのような評価ギャップがハルシネーションリスクを高めているかが理解でき、対策立案の重要性が認識できるでしょう。

私がここ半年ほどのRAG開発活動を通じて注目している対策案としては、GoogleのDataGemmaとRAGを併用してData Commonsという巨大な公開統計情報源に照らしてファクトチェックするRIG(Retrieval-Interleaved Generation)という手法を用いること、また、中国のDeepSeekが政府の統計データを基にファクトチェックと修正を行うDeepRAGという手法があります。

(2)AI活用におけるセキュリティリスクと対応の遅れ

AIに関連するインシデント(事故や不祥事)は2024年に急増し、記録上最多の233件(前年比56%増)に達したといいます。にもかかわらず、「企業においては責任あるAI(RAI)リスクを認識していても、具体的な対応が追いついていない」というギャップがあると指摘されています。部署や職級ごとの知識アクセス権管理や情報漏洩防止といったセキュリティ対策の重要性が浮き彫りになっており、RAG導入時にこの点を軽視すると、情報流出リスクが高まります。同レポートでは、AI導入に伴うセキュリティ上の課題とその深刻さをデータに基づいて理解することができます。知識レコード(チャンク)単位のアクセス権制御を備えたRAG製品を使うと共に、実際にアクセス権を設定・付与する際の適切な社内ルールの必要性が想起されます。

(3)日本語を含むグローバルなAI性能動向の把握

主要ベンチマークにおける米国と中国のAIのモデル性能差が、2024年にはほぼゼロにまで縮小したことが示されています。また、AIモデルの開発が中東・南米・東南アジアなど世界各地に広がっている点も強調されています。これはトップレベルのAIモデルが英語圏以外の地域や市場でも急速に能力を高めていることを意味します。日本市場・日本語環境においても、最新のグローバルAIモデルを活用すれば高い精度が期待できる可能性を示唆する内容であり、日本語対応のベンチマークや評価指標を検討する際の参考になります。

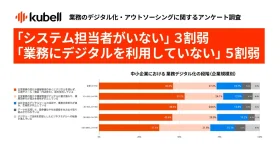

(4)サービス業におけるAI導入事例と効果

企業でAI利用が前例のないペースで拡大しています。24年には「78%の組織がAIを利用している」とされ、前年の55%から大幅な増加となっています。特に生成AIは、23年には企業の33%が業務で利用しているとなっていましたが、24年には71%になっています。また、「AIによって生産性が向上し、スキルギャップの是正にも役立つ」ことを示す研究結果も報告されています。これらのデータは、サービス業においてRAGを活用する現実的なメリット(業務効率化や知識承継、人材育成への寄与)が、すでに多くの企業で実証されつつあることを示しています。実際の導入率や効果に関する記述を読めば、サービス業での具体的な応用例や自社で導入する際のビジネス上の期待効果について具体的なイメージを得ることができるでしょう。

(5)国際的な評価フレームワークとベストプラクティスの動向

HELM SafetyやAIR-Bench、FACTSといった新たなベンチマークが、事実性や安全性を評価する有望なツールとして紹介されています。これはハルシネーション抑制やモデルの安全性向上に向け、国際的にどのような手法・指標が模索されているかを示すものであり、RAGシステムの評価基準を設計・改善する上でも非常に有益です。また、同時に「多くの既存ベンチマークには問題があり、信頼できる標準的な評価の確立が不可欠」と指摘されてもいます。評価手法の標準化はモデルの継続的な改良に欠かせない要素であり、こうした国際的ベストプラクティスの動向を把握することで、自社のRAG導入・運用をより効果的かつ安全なものにブラッシュアップできるでしょう。

(協力=野村直之/AI開発・研究者、メタデータ株式会社社長、東京大学大学院医学系研究科研究員)