Meta「Llama 4」の卓越したスペックを活用しない手はない…AIモデルのゲームチェンジャー?

●この記事のポイント

・Meta「Llama 4」、モデル全体としては巨大なパラメータ数を維持しつつも、実際の計算時には必要な部分だけを効率的に活用

・業界最長の1,000万トークンに対応、従来の約78倍という圧倒的な差

・社内の膨大なドキュメントや過去の事例を学習させ、問い合わせ対応や資料作成、意思決定支援などに役立てることが想定

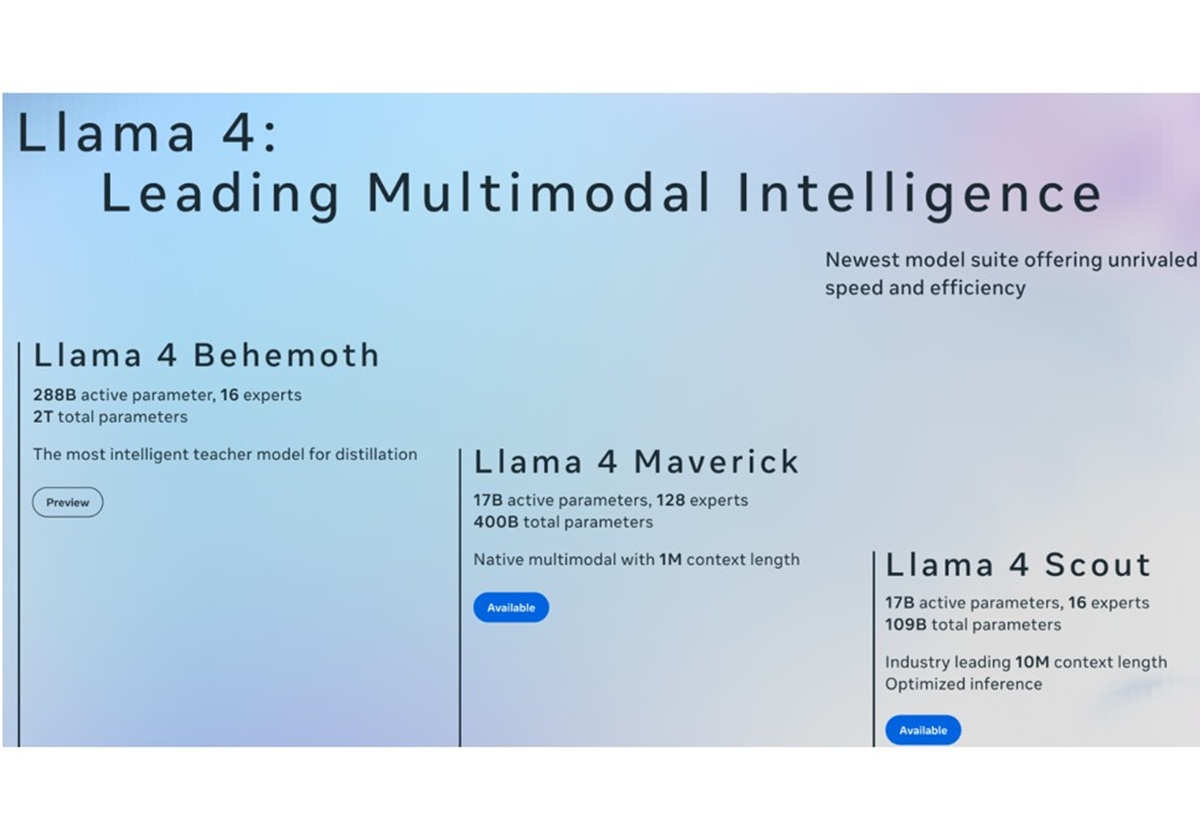

Meta社はAIモデル「Llama 4 Scout」「Llama 4 Maverick」をオープンモデルとして公開した。とはいえ、この手のニュースを見てもあまり驚かない人が多いだろう。AI技術の進化は目覚ましく、新しいモデルやサービスに関する情報が毎週のように発信され、AI関連のニュースはある種の「インフレ状態」とも言えるからだ。では、そのような状況で、今回のMeta社によるLlama 4の発表はいったい、どれほどのインパクトを持つのだろうか。

カスタムAI開発などを通じてクライアントの課題解決を行うLaboro.AIのリード機械学習エンジニア川崎氏に話を聞いた。従来のAIモデルと比較して、今回のLlama 4は具体的にどのような進化を遂げたのか。川崎氏によれば、その特徴は大きく3つあるという。

●目次

- まるで総合医から専門医集団へ。高度に洗練されたMoEアーキテクチャ

- 「本100冊分」相当の1000万トークンに対応、桁違いに圧倒的なコンテキスト長

- AIのトレンドをしっかり捉えたマルチモーダル能力の向上

- Llamaの進化は、オーバースペックか?ゲームチェンジャーか?

- Llama 4の可能性と課題

まるで総合医から専門医集団へ。高度に洗練されたMoEアーキテクチャ

1つ目に挙げたのは高性能なMoE(Mixture of Experts)だ。MoEとは、入力された情報に応じて、その処理に最適な「専門家」にあたるパラメータ群を選択的に使用する仕組みのこと。

「AIモデルは非常に多くのパラメータと呼ばれる要素を内部に抱えています。従来のAIモデルが文章を生成する際には、全てのパラメータを使用して計算する必要があります。高性能なAIモデルになればなるほど必要なパラメータ数が増えるため、計算コストは大きな課題となっていました。その点、Llama 4はモデル全体としては巨大なパラメータ数を維持しつつも、実際の計算時には必要な部分だけを効率的に活用できる。つまり、処理速度の向上や計算コストの削減が期待できます」と川崎氏は説明する。

どれくらい効率的なのか、私たちにとって身近な分野、例えば病院で例えるとわかりやすい。

「従来のAIが総合医のように全ての分野を一手に担当していたのに対し、Llama 4は脳神経外科や循環器内科といった専門医のように細分化された専門知識を持ち、必要に応じて最適な専門医を呼び出すことができるようになっています。リアルな人間社会でも専門分野が細分化されることで高度な対応ができるように、AIもまた、より効率的かつ高度な処理を目指して進化しているのです」

この考え方自体は2018年ごろから存在したが、ChatGPTが登場してから特に大きく発展し、GoogleのGeminiなどでも採用されていると言われている。しかし、Llama 4ではこのアプローチがさらに洗練されているという。

「本100冊分」相当の1000万トークンに対応、桁違いに圧倒的なコンテキスト長

「Llama 4のもう一つの大きな特徴は、扱えるコンテキストウィンドウが飛躍的に大きくなったことです」と川崎氏は強調する。

コンテキストウィンドウとは、AIが一度に理解・記憶できるテキストの量のこと。「作業メモリ」とイメージしてもいい。従来のOpenAIのモデルなどでは約12万8,000トークンが上限だったが、今回発表されたLlama 4 Scoutは、業界最長の1,000万トークンに対応する。これは従来の約78倍という圧倒的な差である。

「この桁違いのトークン数は実用面で大きな違いをもたらすでしょう。従来のAIモデルでは入力できる情報量に限りがありました。そのため、例えば長い文書の内容を理解させたり、複雑な指示を出したりする際には、情報を分割したり、要約したりといった工夫が必要でした。しかし、トークンが飛躍的に増えることで、例えば、分厚いマニュアル全体を読み込ませて特定の情報を引き出させたり、膨大な会話履歴をすべて記憶させた上で次の応答を生成させたりといったことがやりやすくなるでしょう」

限られた作業スペースで工夫して問題を解決していた状態から、広大な作業スペースと潤沢な資料を与えられ、力技で問題を解決できるようになったようなものと言えるだろう。

これまでは、外部の検索システムと連携させるなどして、必要な情報をその都度AIに与えるといった手法(RAG:Retrieval Augmented Generation)が一般的だった。しかし、Llama 4のような巨大なコンテキストウィンドウを持つモデルでは、必要な知識の多くを直接モデル内部に「埋め込む」ような使い方がより現実的になる可能性がある。

ただし、トークンの量が爆発的に増えたからといって、単純には喜べない事情もある。

「いくら大量の情報を入力できたとしても、それをAIが適切に処理し、記憶し、活用できなければ意味がありません。人間がたくさんのビジネス書を読んでも、その内容が頭に残っていなければ役に立たないのと同じように、AIもまた、入力された情報を“理解”し、必要な時に“思い出す”能力が伴わなければ、単に情報が通り過ぎていくだけになってしまいます」

この点に関しては、Llama 4が実際にどの程度の能力を発揮するのか、今後の検証が待たれるところだ。Meta社自身も、発表時点ではまだ限定的なテストしか行えていない可能性があり、その真価が明らかになるには時間がかかるかもしれない。

AIのトレンドをしっかり捉えたマルチモーダル能力の向上

川崎氏が3つ目の特徴として挙げたのは、マルチモーダル能力の向上だ。マルチモーダルとは、テキストだけでなく、画像や音声など、複数の異なる種類の情報を統合的に扱える能力を指す。

「ただし、正直なところ、この点に関しては、ここ数か月で他のモデルも同様の機能を発表・強化しており、Llama 4が突出して新しいというわけではありません。しかし、着実に進化しているという印象です。他社が先行している部分もあるかもしれませんが、Meta社もキャッチアップし、中堅どころ、あるいはそれ以上のポジションを確立しつつあると言えるでしょう」

最近のAIモデルのトレンドとして、このマルチモーダル対応は非常に重要視されており、Llama 4独自の進化というよりは、「AI業界のトレンドにしっかり押さえている」と言ったほうがいいだろう。

Llamaの進化は、オーバースペックか?ゲームチェンジャーか?

気になるのが、今後Llama 4の活用が期待される分野だ。

「まず考えられるのは、企業内での利用です。特に、セキュリティ上の理由から社外に情報を持ち出すことができないような機密情報や顧客データなどを扱う業務。自社環境内にLlama 4を導入し、活用するケースは増えるのではないでしょうか。

具体的には、社内の膨大なドキュメントや過去の事例を学習させ、問い合わせ対応や資料作成、意思決定支援などに役立てることが考えられます。ほかにも、社内の規定、マニュアル、過去の議事録などを全てLlama 4に読み込ませ、それに基づいて社員からの質問に答えたり、必要な情報を提示したりするシステムを作る企業が出てもおかしくありません」

このような活用方法は他のモデルでも実現可能だが、Llama 4のオープンソース性、そして持つ巨大なコンテキストサイズや処理能力は、より高度で正確な応答を可能にする。

「Llama 4の卓越したスペックを最大限に活かせる分野としては、例えば、膨大な量の判例や法律文書を瞬時に分析する必要がある法曹界、複雑な金融商品を多角的に評価する金融業界、あるいは大量の学術論文や研究データを解析し新たな知見を求める研究開発分野などが考えられます」

逆に言えば、一般的な用途においては、Llama 4の性能はオーバースペック気味になる可能性も否定できない。川崎氏も「実際にLlama 4を導入し、活用するにはいくつかのハードルも存在します」と釘を刺す。

「その一つが、計算資源の確保です。Llama 4のような大規模モデルを快適に動作させるためには、非常に高性能なコンピューターが必要となります。例えば、一般的なMacBook Proのような消費者向けのマシンでは到底太刀打ちできず、それよりもはるかに高性能な、専門的なハードウェア環境を用意しなければなりません」

例えるなら、AIという“非常に優秀な専門家”を雇うことはできても、その専門家が働くための“高度な設備や研究室”を用意する必要がある、といったイメージに近いかもしれない。人件費は抑えられても、設備投資は依然として必要になるのだ。

Llama 4の可能性と課題

今回のLlama 4の進化は、順調なステップアップと見るべきか、それとも飛躍的なブレイクスルーと見るべきか。

「基本的には着実な進化の延長線上にあると考えられます。ただし、特にコンテキストサイズの拡大などは、他の有力なプレイヤーと比較しても目を見張るものがあります。Meta社は、GoogleやOpenAIといった競合他社としのぎを削る中で、独自の強みを発揮しようとしているのではないでしょうか」

巨大テック企業によるAI開発競争が激化するなか、Metaの持つ強みとは。

「Metaの強みは、Llamaモデルをオープンソースとして公開していることです。セキュリティを気にする企業に選ばれやすいのが一つ。そして、モデルの中身を実際に見ることができるため、さまざまなコミュニティが使用し、その知見を共有できるという点で独自のポジションを確立しています。これは他の大手AIプロバイダーとは異なるアプローチです」

今後のLlama 4の展開について、川崎氏は次のように締めくくった。

「現時点では、まさに“蓋を開けてみないとわからない”というのが正直なところです。今後、開発者コミュニティがLlama 4をどのように活用し、どのような新たな可能性を見出していくのか。Llama 4の真価は、これから実際に企業や開発者の手に渡り、さまざまなユースケースで試される中で徐々に明らかになっていくでしょう」

(文=加藤純平/ライター、協力=Laboro.AI)